小睿助理部署文档

先决条件

-

需要客户提供调用LLM的接口,即客户可以在自己的环境中部署自己的LLM,也可以使用云厂商(eg: 火山引擎,百度云平台,阿里云平台)的LLM,只要提供调用LLM的接口url, key等即可。这些接口需要按照国内外通用LLM的openai规范。如下是火山引擎的调用DeepSeek-R1接口url和key等示例。

model.platform=volcengine

model.name=deepseek-r1-250528

model.api.key=abc123(use your own key)

model.base.url=https://ark.cn-beijing.volces.com/api/v3 -

需要客户提供嵌入模型和ReRanker模型的接口,嵌入模型是将文本转换为嵌入向量所必须的模型,同时ReRanker模型是用于检索知识库时对检索到的结果进行排序,可以提高检索知识库的准确性。同样,这两个模型的接口,客户可以在自己环境中部署这两个模型,也可以用云厂商(eg: 火山引擎,百度云平台,阿里云平台)的模型接口。我们内部使用的嵌入模型是Qwen3-Embedding-4B,ReRanker模型是:bge-reranker-v2-m3,客户可以选用自己的嵌入模型和ReRanker模型,由于模型不同,可能会影响最终准确率。

-

需要部署两个服务:chat-service 服务和 milvus-service服务,这两个服务都支持Docker环境和K8S部署,所需要的资源:chat-service + milvus-service,一共2台8C16G,milvus-service部署时仅仅部署一个节点,尽量选用SSD硬盘,不然影响查询速率。

部署步骤

- chat-service 服务和 milvus-service服务的部署与公司其他组件的部署方式一样,可以用Ansible直接部署。

- Ansible部署步骤:

- 准备Ansible环境,获取Ansible包:联系架构部或从资源下载平台获取包含chat-service组件和milvus-service组件的Ansible包(例如:one_chat_service_X.X.X.X_increment.tar.gz)。

- 上传并解压:eg:

tar -xvf one_chat_service_3.3.1.0_increment.tar.gz -C /data/ansible - 修改部署参数:修改hosts.ini里面的内容,指定部署chat-service和milvus-service的机器IP

- 修改all.yml文件:在

/data/ansible/gaea/group_vars/all.yml中设置chat_service的版本号(需与DevOps平台打包的版本一致),有时该版本号已经确定,则无需修改。 - 执行部署命令:进入Ansible的bin目录并运行安装命令:sh br.sh --install -t chat_service -S -vvv

- 验证部署后的服务状态:docker ps -a | grep chat_service # 确认容器正常运行。

- 具体的步骤可能因chat-service版本不同而有所调整,部署前需要和AI团队确认好版本和具体步骤。

- 由于LLM根因分析依赖调用链数据,日志数据,告警数据等,故而对APM, RUM, Log,Alert等组件有依赖,不同的chat-service版本所依赖的其他组件版本不同,需要和AI团队确认好依赖的其他组件情况。

- 最好先部署milvus-service服务,然后部署chat-service服务。

- 部署后检查服务是否正常:

-

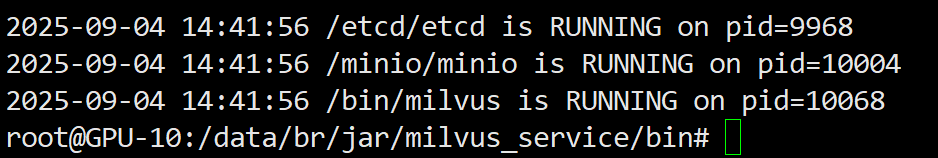

部署milvus-service后,通过docker exec -it br-milvus-service bash进入容器内部,使用

bash milvus_service.sh 6出现的各进程都是RUNNING则表示正常,如下:

-

部署chat-service后,通过docker exec -it br-chat-service bash进入容器内部,使用

bash chat_service.sh 6出现的各进程都是RUNNING则表示正常。(与上图类似)

部署后配置LLM参数

- 部署了chat-service和milvus-service后,需要首先配置LLM,嵌入模型,ReRanker模型的接口地址,配置方法:在nacos的chat-service的私有配置(默认:CHAT_SERVICE,可能有改动)的内容:

-

修改LLM接口参数:

model.platform=volcengine

model.name=deepseek-r1-250528

model.api.key=abc123(use your own key)

model.base.url=https://ark.cn-beijing.volces.com/api/v3 -

修改副LLM接口参数(副LLM通常是比较快速的其他模型,如果没有,可以设置为和上面LLM一样):

# 副LLM大模型的配置

sub.model.platform=volcengine

sub.model.name=doubao-seed-1-6-flash

sub.model.api.key=(use your own key)

sub.model.base.url=https://ark.cn-beijing.volces.com/api/v3

# third LLM大模型的配置,如果没有,可以配置为和上面LLM一样

third.model.platform=volcengine

third.model.name=doubao-seed-1-6-flash

third.model.api.key=(use your own key)

third.model.base.url=https://ark.cn-beijing.volces.com/api/v3 -

修改嵌入模型和ReRanker模型的接口地址:

# 嵌入模型对应的配置

embedding.model.name=br-embedding(use your own name)

embedding.model.key=(use your own key)

embedding.model.url=http://ip:port/v1(use your own url)

# rerank模型对应的配置

rerank.model.name=br-rerank(use your own name)

rerank.model.key=(use your own key)

rerank.model.url=http://ip:port(use your own url)

- 配置完成后,需要使用docker restart br-chat-service来重启服务。